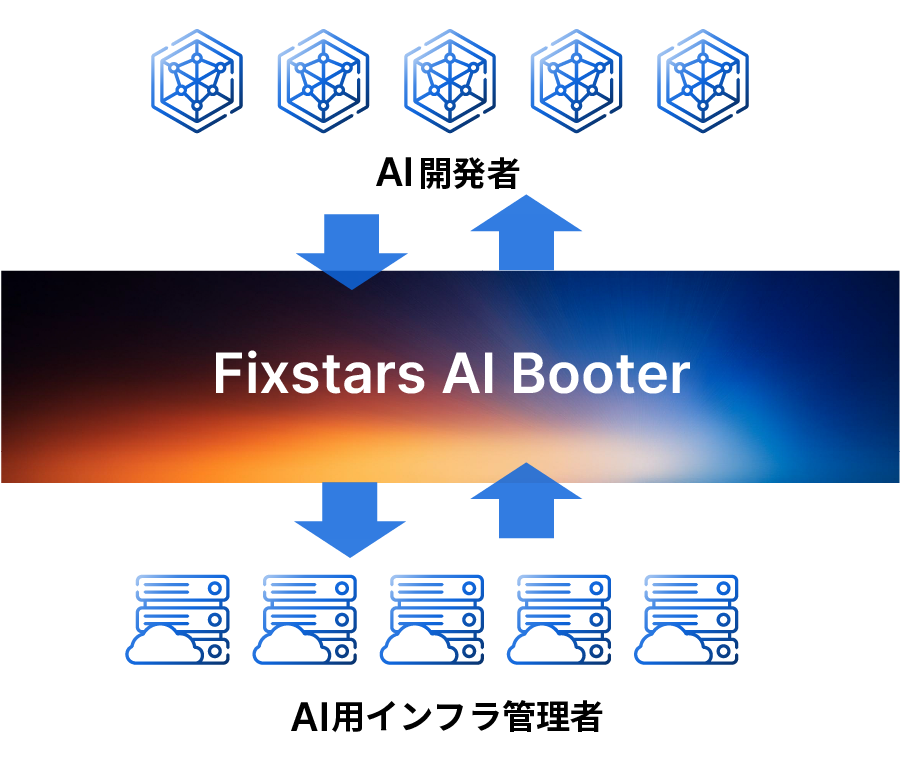

Fixstars AIBoosterとは

GPUサーバーに

-

AI学習や

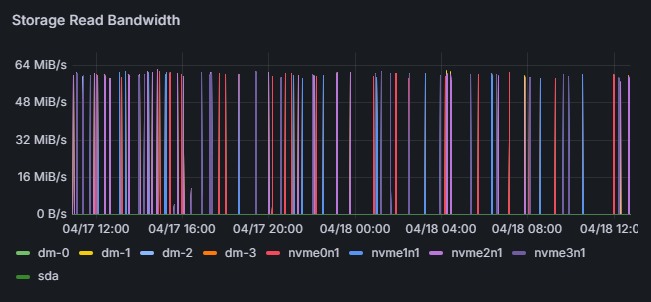

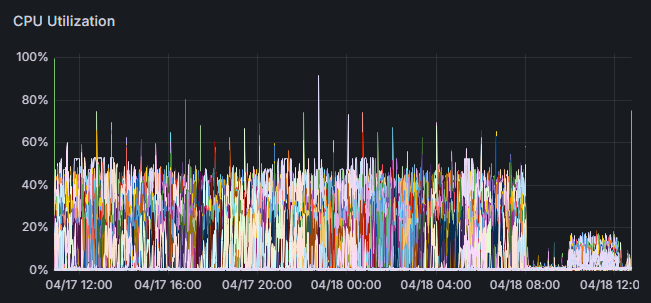

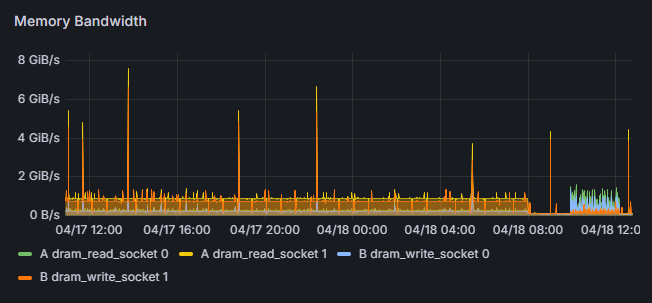

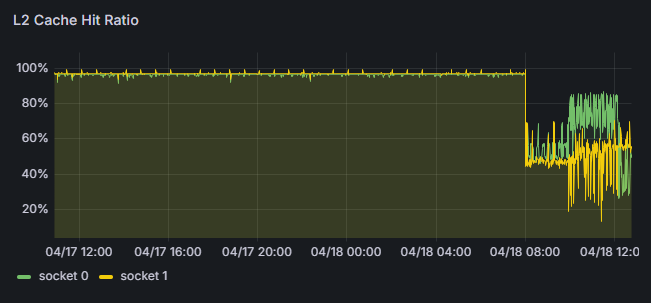

推論などの パフォーマンス情報を 常に 監視・保存 -

性能の

劣化や 処理の ボトルネックなどを 可視化

-

パフォーマンス観測で

収集された データを もとに、 自動で 高速化する ための ツール群を 提供 -

Performance

Observabilityが

提供する データを もとに、 ユーザーが 手動で 高速化する ことで、 更なる パフォーマンス改善が 可能

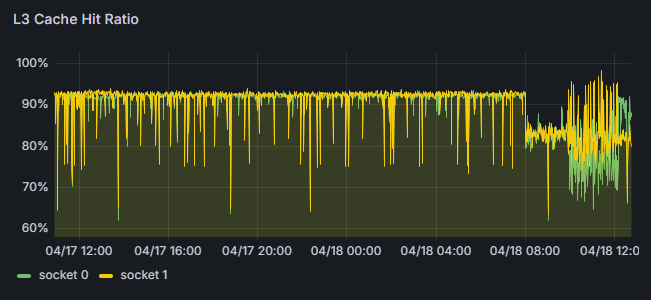

パフォーマンス観測機能

パフォーマンス改善機能

分析

POビューワーを

高速化

-

分析結果を

もとに、 自動で 高速化する ための ツール群を 提供 -

高速化に

必要な ドキュメントを 提供。 これを 利用して、 ユーザーが 手動で 高速化を 実現可能

パフォーマンスエンジニアリングサービス(要問い合わせ)

さらなる

アプリケーションの

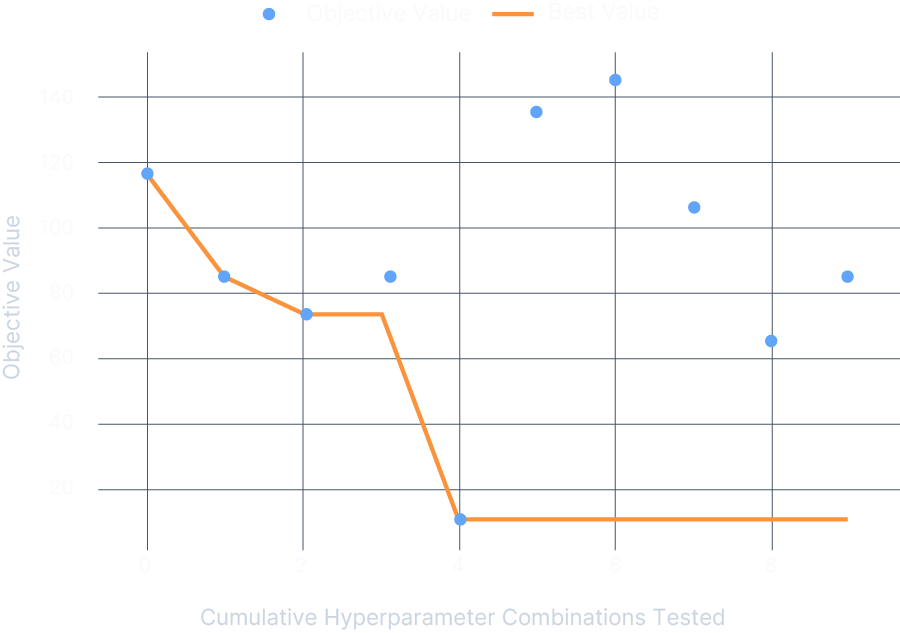

深層学習モデルの

- 複雑なモデル構造:最新AIモデルは巨大で複雑な構造

- 手動最適化の限界:全パターンの手動変換は工数が膨大で現実的でない

- 専門知識の必要性:GPUやTensorRTの深い技術知識と経験が必要

PyTorchで

PyTorchモデル

複雑なマルチモジュール構造

自動構造解析

モジュール構造を自動把握

段階的最適化

完全自動で最適化を実行

最適化済みモデル

すぐに利用可能パフォーマンス改善サイクル

パフォーマンスは

-

新モデル/新手法の採用

Transformerアーキテクチャの更新や マルチモーダル化などに より、 計算パターンが 変わり、 GPU利用率や メモリ帯域の バランスが 崩れる -

ハードウェア構成・クラウドプランの変更

インスタンスタイプのサイズ変更、 価格改定、 リージョン移行などに より、 コスト最適だった 構成が 陳腐化し、 過剰リソー スや 性能不足を 招く -

ライブラリ/フレームワークのアップデート

CUDA・cuDNN・PyTorchなどのバージョンアップなどに より、 内部アルゴリズムや メモリ管理が 変わり、 想定外の レイテンシ増大や メモリフットプリント悪化が 発生

常に最高のパフォーマンスを得ることができます。

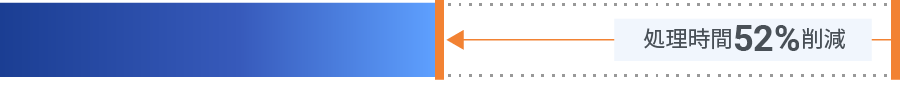

Fixstars AIBoosterによる高速化実績

-

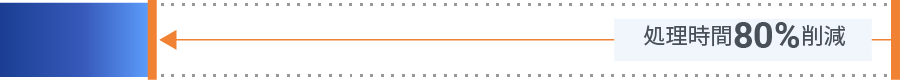

放送会社様・LLM70Bモデル継続事前学習

-

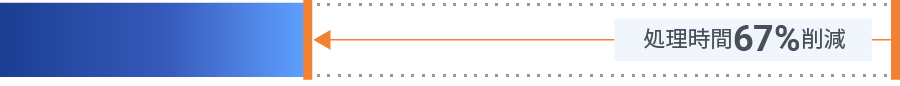

通信会社様・LLM70Bモデル継続事前学習

-

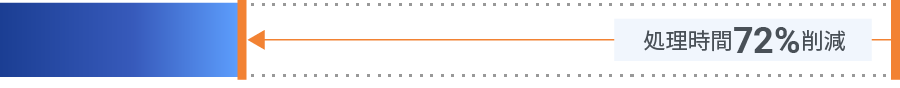

LLM7Bモデル学習

-

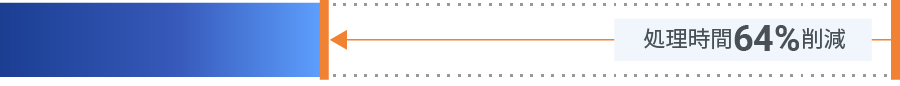

LLMシングルバッチ推論

-

LLMマルチバッチ推論

※Fixstars AIBoosterの自動高速化と、取得したパフォーマンスデータを元にした手動高速化の両方の結果を含む

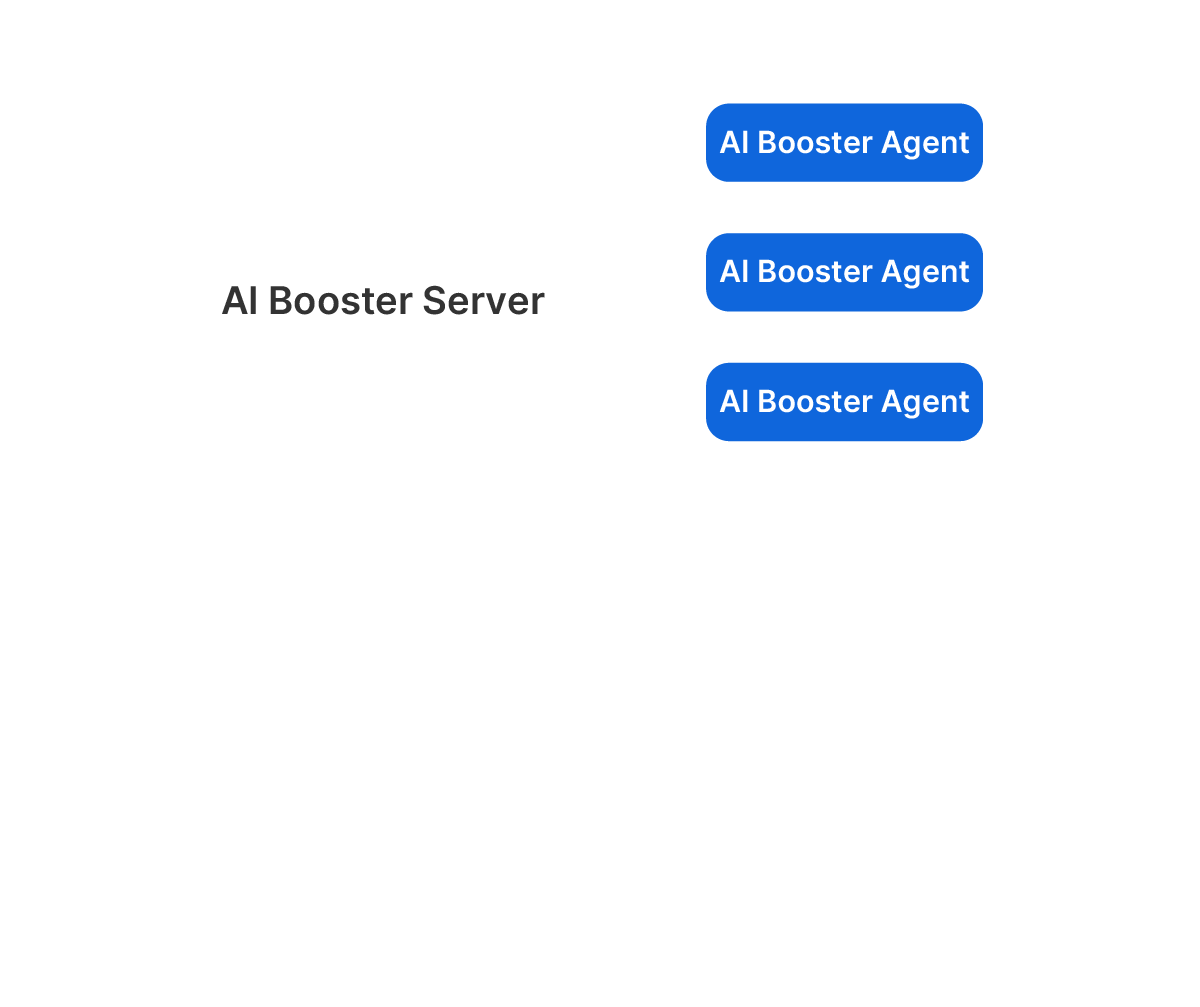

システム構成

AIBoosterは、次の2つのコンポーネントで構成されます。

AIBooster Agent

Agentは

AIBooster Server

Serverは

AIBoosterは、

システム構成例

全てをオンプレミス環境で構築・セキュリティ上、外部のサービスを利用できない方向け

管理ノードを

ユーザーは

多くの

よくある質問

Linuxデーモンのように、システムに常駐しますので、オーバーヘッドはゼロではありませんが、システムリソースを極力消費しないように設計しています。我々は、”Near-Zeroオーバーヘッド”と呼んでいます。

Debian系のLinux環境で動作します。弊社で動作確認をしているディストリビューションはUbuntu 22.04 LTSです。NVIDIA GPUがない環境でも動作可能ですが、取得できる情報や機能が限られます。

現在配布されているFixstars AIBoosterは無償でご利用可能です。ただし、パフォーマンス・インテリジェンス(PI)に関する機能は利用開始後、1ヶ月間は無償で、その後有償となります。詳細な利用規約については、Fixstars AIBoosterエンドユーザーライセンス契約を参照ください。

Fixstarsは、ユーザーのアプリケーション情報、POによる分析結果など、ユーザー固有のデータを取得していません。プロダクトの改善のために、プロダクトの利用状況に関するデータのみ取得しています。詳細はお問い合わせください。

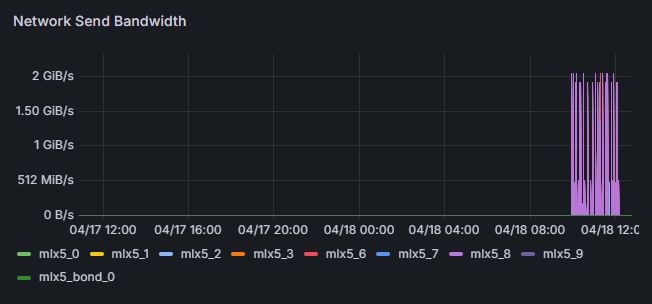

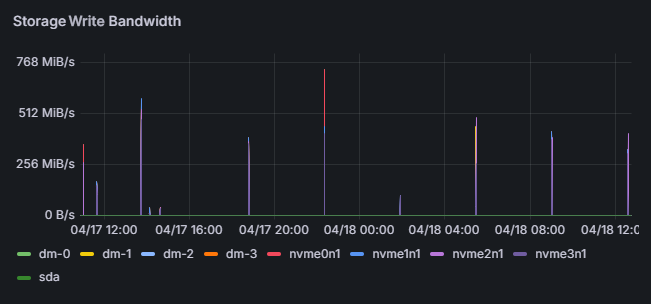

DataDog, NewRelicなど、従来のパフォーマンス観測ツールでも、ハードウェアの利用状況等を見ることはできますが、Fixstars AIBoosterの場合、AI処理の詳細も取得・可視化しています。さらに、得られたデータから、パフォーマンスのボトルネックを分析・改善します。

パフォーマンス観測(PO)の結果を元に、利用しているインフラの構成を変更したり、処理の際のパラメーターを変えたり、GPUの性能を最大限引き出すソースコードに変更するなど、様々な高速化手法を組み合わせて改善します。ただし現時点では、自動で改善される項目は限られます。

NVIDIA Nsightなどのプロファイリングツールは、特定のコマンドをトリガーとして、処理の詳細の”スナップショット”を取得するものです。AIBoosterは、システムで実行された処理の詳細を常時取得しています。これにより、性能劣化の原因を過去に遡って調査・分析可能です。また、パフォーマンス改善の提案や自動適用は、他にはないAIBoosterならではの機能です。

はい、できます。基本的な技術は大きく変わらないため、他のAIやGPU処理も、Fixstars AIBoosterによって速くなることが期待できます。具体的な効果については処理内容によって変わりますので、お問い合わせください。

他にご質問はございますか?お問い合わせください